Lorsque vous lancez un site web ou un blog, il n’est pas rare de constater du trafic résiduel provenant des robots de spam dans vos rapports Google Analytics. Souvent, c’est une augmentation des visites avec la langue .ru qui met la puce à l’oreille…

Ces robots sont devenus une vraie problématique pour les éditeurs de sites et les webanalystes. Pour preuve, une récente étude estime que 56% du trafic Internet est réalisé de nos jours par des bots.

Pour essayer de résoudre ce problème, la première action à effectuer est de se rendre dans Admin > Vue > Paramètres de la vue puis de cocher le filtrage des robots comme sur le screenshot ci-dessous :

Pour autant, ce filtrage n’est pas garanti à 100%. Il est possible de constater des visites de robots dans l’analyse Acquisition > Tous les sites référents même après la mise en place du filtrage automatique prévu par Google.

Voici une petite liste des URLs de bots les plus souvent rencontrées :

- forum.darodar.com

- priceg.com

- iloveitaly.com

- econom.co

- blackhatworth.com

- …

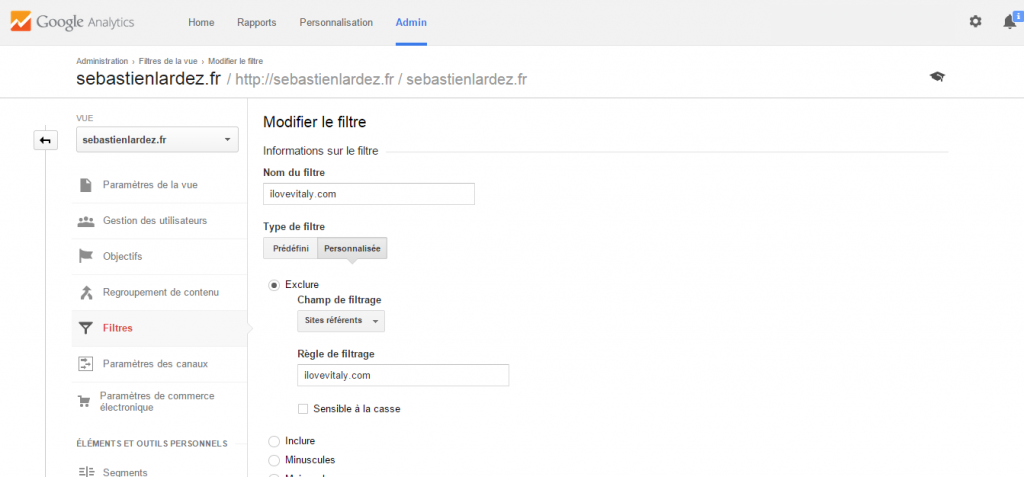

Une fois les robots identifiés, vous pouvez donc mettre en place des filtres d’exclusion personnalisés. Dans Admin > Vue > Filtres, donnez un nom à votre filtre, choisissez le type de filtre « personnalisé » et optez pour les sites référents en champ de filtrage. Dans mon exemple, j’ai créé un filtre sur le domaine iloveitaly.com :

Avant d’effectuer toute modification, une bonne pratique est de créer une nouvelle vue, sur laquelle les filtres sont configurés, ce qui permet de garder la vue originale pour comparer les données.

Il existe d’autres possibilités pour empêcher la pollution de ses rapports par les bots. Sur Google Analytics, vous pouvez également créer des segments, qui excluent le trafic des robots de vos rapports, tout en conservant la donnée si besoin.